Die Faszination der Entropie, Teil 1

Synonym für das größte, nicht entschlüsselte Geheimnis

Der Begriff "Entropie" faszniniert mich schon seit langer Zeit. Er hat keine "Griffigkeit" wie andere abstrakte Begriffe, keinen philosophie-historischen Background, ist aber dennoch in gleich drei Wissenschaften - Physik (Thermodynamik), Informatik und Soziologie - präsent, meint dort jeweils etwas anderes, impliziert aber auch Gemeinsamkeiten.

In diesem Essay möchte ich ein wenig beschreiben, wie ich mich diesem Begriff stetig annähere - Erkenntnis selbst ist quasi die Entropie des Verstandes. Egal, wie viel ich hier geschrieben habe - es ist noch längst nicht alles gedacht und schon gar nicht gesagt. Es gibt noch keine philosophische, genauer, ontologische Definition der Entropie. Das hier sind versammelte Gedanken als deren Grundlage.

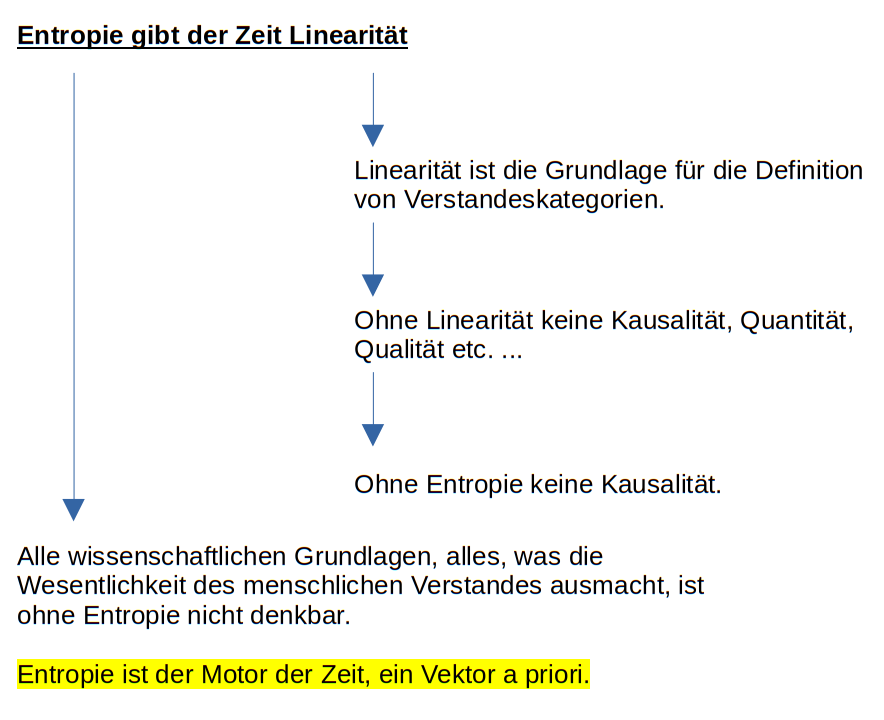

Den wichtigsten Gedanken gleich vorab: Entropie ist das, was der Zeit Linearität gibt. Sie ist im Menschen als Alterungsprozess angelegt und bildet die größte Barriere im menschlichen Dasein, welches versucht, über das tatsächlich für den Verstand Erfahrbare hinauszublicken.

Definitionen von Entropie

Aber beginnen wir zunächst mit den Definitionen (Quelle: wikipedia, teils etwas gekürzt):

Entropie in der Physik (Thermodynamik)

Die Entropie ist eine in der Thermodynamik definierte physikalische Größe von fundamentaler Bedeutung. Sie ist eine der Zustandsgrößen eines makroskopischen Systems und hat unter anderem folgende Eigenschaften:

- In einem abgeschlossenen System, das sich durch spontane innere Prozesse [...] dem thermodynamischen Gleichgewicht annähert, steigt die Entropie des Systems durch diese Prozesse an. Der Gleichgewichtszustand ist erreicht, wenn die Entropie den größtmöglichen Wert erreicht, der mit den gegebenen äußeren Parametern des Systems verträglich ist.

- Entropie kann nicht vernichtet werden. Ein Prozess, bei dem Entropie entstanden ist, kann nicht rückgängig gemacht werden, ohne dass die entstandene Entropie an die Umgebung des Systems abgegeben wird.

- Das Anwachsen der Entropie durch jeglichen spontanen Prozess definiert in der Physik die Richtung der fortschreitenden Zeit.

Entropie in der Soziologie

Der Begriff der Entropie bzw. der sozialen Entropie fand in die Sozialwissenschaften, insbesondere in das Gebiet der Soziologischen Systemtheorie innerhalb der Soziologie, Eingang als ein ursprünglich aus der Physik übernommenes Maß für Ungleichheit oder Unordnung. Sie wird zumeist als ein Maß für den Grad der Ordnung bzw. Unordnung innerhalb eines sozialen Systems verstanden, beispielsweise zur Beschreibung der sozialen Ungleichheit. Teils wird als soziale Entropie auch anstelle eines skalierbaren Maßes die Tendenz zur Veränderung sozialer Strukturen verstanden.

Eine der menschlichen Intuition entgegenkommende Weise, die Bedeutung von Entropie verständlich darzustellen, besteht darin, nicht die Entropie selbst, sondern die Veränderung von Entropie zu betrachten, also die Zunahme oder die Verringerung von Entropie.

- Entropiezunahme ist Informationsverlust: „Eine Zunahme der Entropie bedeutet Informationsverlust und nichts Anderes.“

- „Entropie ist Informationsmangel, dessen Größe an dem Aufwand gemessen wird, der zur Behebung dieses Informationsmangels erforderlich wäre.“

- Zur Entropieverringerung benötigt ein System seine Umwelt: Ein System kann seine Entropie nur durch die Belastung seiner Umwelt verringern. Dazu muss es offen sein. Verringert eines seiner Subsysteme seine Entropie, so muss entweder die Summe der Entropien der übrigen Subsysteme im Gesamtsystem ansteigen oder das Gesamtsystem muss seine Umwelt mit Entropie belasten.

- Entropiezunahme verringert die Veränderungsfähigkeit eines Systems: Ein System mit niedriger Entropie kann sich leichter ohne Belastung seiner Umwelt verändern als ein System mit hoher Entropie. Verändert sich ein System unabhängig von seiner Umwelt, dann nimmt seine Entropie zu. Ein System mit maximaler Entropie kann sich aus eigener Kraft überhaupt nicht mehr verändern. Diese beiden Tatsachen treffen auf die Subsysteme eines Systems gleichermaßen zu.

Entropie in der Informatik

Entropie ist in der Informationstheorie:

- einfach gesagt: die durchschnittliche Anzahl von Entscheidungen (bits), die benötigt werden, um ein Zeichen aus einer Zeichenmenge zu identifizieren oder zu isolieren,

- anders gesagt: ein Maß, welches für eine Nachrichtenquelle den mittleren Informationsgehalt ausgegebener Nachrichten angibt.

Der Begriff ist eng verwandt mit der Entropie in der Thermodynamik und statistischen Mechanik.

Entropie ist ein Maß für den mittleren Informationsgehalt pro Zeichen einer Quelle, die ein System oder eine Informationsfolge darstellt. In der Informationstheorie spricht man bei Information ebenso von einem Maß für beseitigte Unsicherheit. Je mehr Zeichen im Allgemeinen von einer Quelle empfangen werden, desto mehr Information erhält man und gleichzeitig sinkt die Unsicherheit über das, was hätte gesendet werden können.

Erklärungen und Verbindungen zu diesen Definitionen

Da ich weder Physiker noch Soziologie, aber ein bisschen Philosoph und (ein bisschen mehr) Informatiker bin, fasziniert dieser Begriff insbesondere in der Ontologie, also der Erkenntnistheorie, die in der "Kritik der reinen Vernunft" von Kant ihre wichtigsten Grundlagen findet. Der Begriff fasziniert deswegen, weil er bei Kant gar nicht auftaucht, aber eigentlich allgegenwärtig sein müsste. Kant wusste nichts von heute geläufigen Definitionen.

Kant hat Rationalismus und Empirismus miteinander vereint, in dem er an den Anfang seiner Überlegungen den Gedanken stellt, welche Grundlagen gegeben sein müssen, damit ein Verstand denkfähig ist, unabhängig von den Eigenschaften der Welt und den in ihr enthaltenen Dingen. Was bleibt übrig, wenn wir versuchen, alles an Eigenschaften (bei Kant "Akzidenzien") wegzudenken? Laut Kant sind es Raum und Zeit. Der Mensch ist nicht in der Lage, sich etwas ohne räumliche und zeitliche Ausdehnung vorzustellen. Raum und Zeit bilden so etwas wie eine Ratio a priori - sie haben empirische Realität und transzendentale Idealität. Sie sind Gefäß und Filter unserer Verstandestätigkeit und setzen dieser gleichzeitig Grenzen. Kant leitet hieraus die Verstandeskategorien ab - die Zeit bildet hierbei die Linearität und ist die "Synthesis der Mannigfaltikeit im Raume".

Obwohl Kant den Begriff der Entropie nicht kennt, definiert er den Begriff "Augenblick" als die Wahrnehmung des Verfließens der Zeit, als Bewegung in Relation zu einer beharrlichen Wahrnehmung. Damit kommen wir einer ontologischen Defintion von Entropie, welche sich in die drei genannten Definitionen einreihen würde, schon sehr nahe.

Ich würde diesen Gedanken gerne mit der nun folgenden, logischen Konsequenz vervollständigen:

Was bedeutet aber Entropie in Bezug auf den Menschen ganz konkret? Nun, die Entropie ist zum Beispiel der Stoffwechsel biologischer Organismen. Die Entropie ist demnach in uns Menschen als Alterungsprozess angelegt. Entscheidend ist hierbei das "in uns" - d.h. die Wahrnehmung von Linearität ist subjektiv. Wir können, selbst wenn wir Entropie in wiederkehrenden Jahreszeiten, in Anfang, Ende und Vergänglichkeit sehen, ihre Bedeutung als Linearität nicht objektiv abstrahieren. Wir können also nicht objektiv - wissenschaftlich - feststellen, dass die Zeit objektiv tatsächlich eine Dauer hat, denn die Dauer mag vielleicht nur eine Empfindung sein, die der Tatsache geschuldet ist, dass Entropie nicht umkehrbar ist.

Arthur Schopenhauer, der sich als Vollstrecker Kants bezeichnet hat, schreibt hierzu: "Alles was in der Zeit ist hat eine Dauer" und sagt gleichzeitig "Die Zeit selbst hat keine Dauer, sondern alle Dauer ist in ihr, und ist das Beharren des Bleibenden, im Gegensatz ihres rastlosen Laufes." Er sagt außerdem, dass die Zeit nicht an sich messbar sein, sondern nur durch Bewegung im Raum. Bewegung ist erkenntnistheoretisch nur ein anderes Wort für Entropie - oder: "Die Zeit macht den Wechsel der Accidenzien [Eigenschaften] möglich".

Ontololgische Klassifizierung

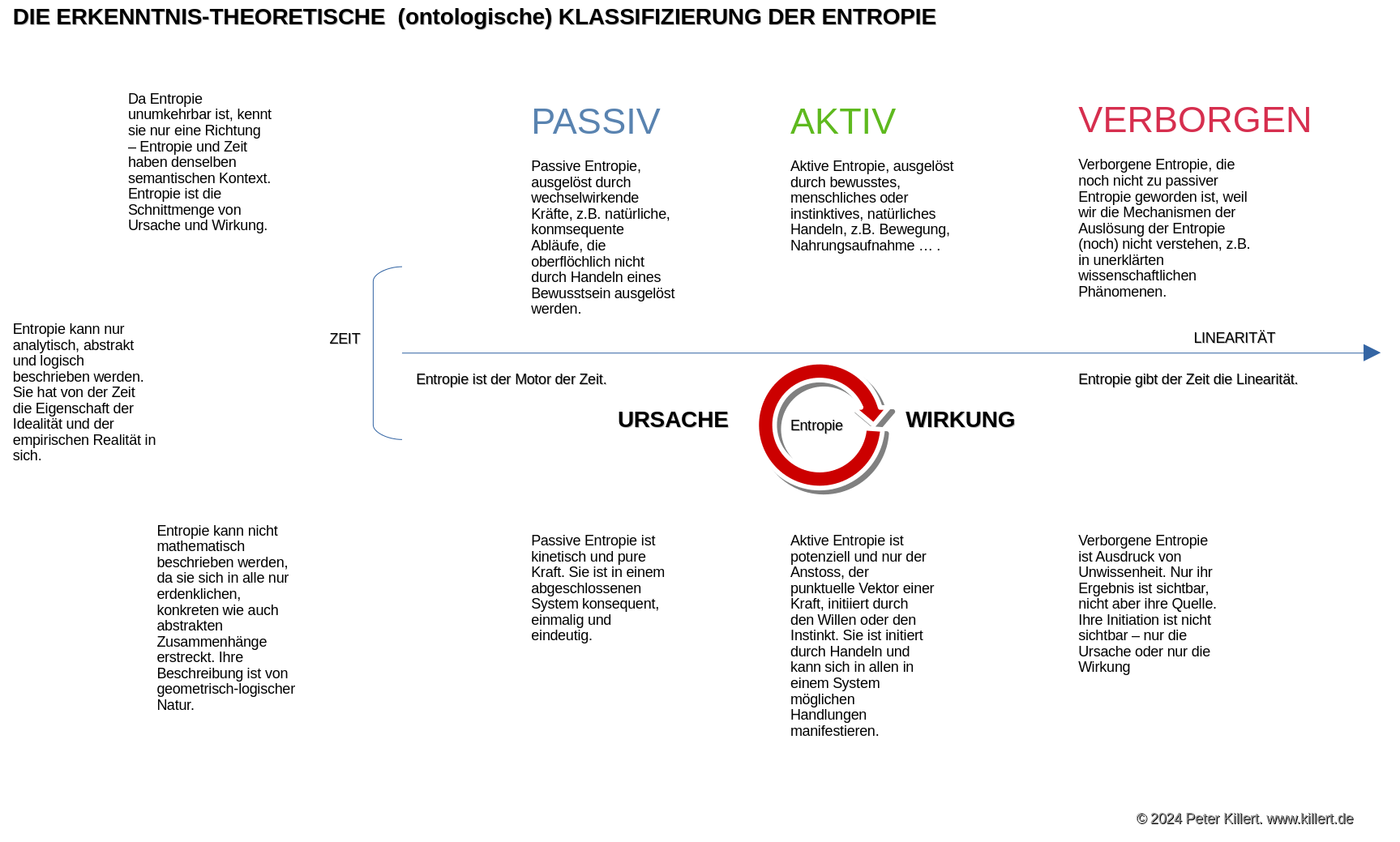

In meinen Überlegungen unterscheide ich in drei Klassen von Entropie, wobei diese Überlegungen noch nicht so gefestigt sind, dass sie nicht durch weitere Recherche verändert werden könnten. Ich unterscheide in - passive - aktive - verborgene

Entropie. Ich würde ggf. auch so etwas wie "statische" Entropie definieren, wobei ich mir nicht sicher bin. Dazu später noch mehr ... .

Ableitungen aus diesen Definitionen

Welche der drei genannten Definition man auch heranzieht - es drängen sich Begriffe wie "Gleichgewicht", "Veränderung" und "Verlust" auf. Definieren wir das mal etwas genauer, zunächst auf einer einfachen Ebene:

- Entropie ist Veränderung: Ich würde fast sagen, Entropie ist ein Synonym für Veränderung.

- Entropie ist immer ein Wechselspiel zwischen ihrem Gegenstand und der Umgebung: Oder - Entropie benötigt Subjekt und Objekt.

- Die Definition von Entropie hat als Bezugsgröße eine Art Gleichgewicht in deren Ausformung sie unsichtbar zu werden scheint.

Die ersten beiden Sätze sind einleuchtend. Entropie gibt es in jeder Art von Stoffwechsel und ein Stoffwechsel ist eine Veränderung, eine Bewegung. Die dritte Ableitung ist mir selbst in den Sinn gekommen. Wären wir uns der fortwährenden Entropie ständig bewusst, dann würden wir uns auf nichts anderes konzentrieren können. Entropie ist also etwas, das - wenn es im Gleichgewicht ist - unsichtbar ist. Unsichtbar im Sinne von nicht sichtbar in unserem Alltag. Wir sehen nicht, wie sich der Stoffwechsel in unseren Zellen abspielt. Wir sehen das Verwittern des Blattes eines Baumes nicht ständig bewusst (es sei denn wir schauen uns einen Film im Zeitraffer an). Entropie ist messbar. Zu einem bestimmten Zeitpunkt. Ihre Eigensart wird durch das aneinanderreihen der Ergebnisse in linearer Folge erst sichtbar - ich würde daher sagen, die Entropie ist "augenblicksaffin". In etwa das, was Kant in seiner Definition von Zeit angeführt hat. Die Entropie macht den Augenblick meßbar und ist gleichzeitig ihr steter Fluß. Die Entropie ist daher weder Ursache noch Wirkung an sich. Man kann sie auch nicht mit Zeit oder Linearität gleichsetzen, da sie nur das Wechselspiel von Ursache und Wirkung illustriert. Es stellt sich also die Frage - was genau ist die Entropie, möchte man sie philosophisch einordnen?

Ist die Entropie eine Kraft?

Nein, denn Entropie ist definiert als "Joule pro Kelvin", d.h. Energie ist Teil ihrer Definition und bindet damit physikalische Kraft an sich. Sie scheint den pyhsikalisch bekannten Kräften übergeordnet zu sein. Die beste Definition ist "Zustandsgröße" oder "Vektor", wobei "Vektor" fast schon zu profan ist. Das wäre so, als würde man sagen, die Farbe ist bunt.

Da meine Definition von Entropie aber nicht rein physikalisch zu verstehen ist - wie ich eingangs dargelegt habe ist Entropie physikalisch, informationstechnisch und sozialwissenschaftlich definiert, nicht aber philosophisch - fühle ich mich ein wenig freier in der Definition. Auch wenn das jetzt ein wenig sehr prosaisch wirkt: die Entropie ist durchaus ein Kraft oder so etwas wie das Zustandsgefäß von Erkenntnis. Sie schwingt in der Definition von Zeit mit, impliziert aber auch einen abstrakten, erkenntnistheoretischen Bereich.

Wird ein in sich geschlossenes System komplexer, dann steigt die Entropie und das Gleichgewicht innerhalb des Systems gerät in Gefahr. Das trifft auf alle drei Teilbereiche zu, in denen Entropie definiert ist. Wird ein physikalisches System, etwa ein Motor, immer mehr überladen, immer mehr steigender Entropie ausgesetzt, dann droht das Systen zu kollabieren. Wird ein informationstechnisches Konstrukt mit Informationen überladen, droht auch hier ein Kollabieren des Gleichgewichtes - Erkenntnis wird unmöglich. Entropie als Gleichgewicht ist also fundamental für das funktionierende Existieren von physikalischen Systemen und sie ist fundamentale Grundlage von Erkenntnis. Sozialwissenschaftliche Implikationen sind dann zwangsläufig. Das ist eine faszinierende Gemeinsamkeit dieser Begrifflichkeit. Es gibt nur wenige Begriffe, die zwischen der konkreten Beschreibung der Welt durch Mathematik und der abstrakten Welt der Ontologie eine Brücke schlagen können. Sozialwissenschaftliche Anhängsel machen das dann noch interessanter - auch das wird in einer Fortsetzung des Essays behandelt werden.

Verlassen wir also die naturwissenschaftliche Ebene nach Feststellung diese Gemeinsamkeit - dann kommen neben den genannten Begriffen "Gleichgewicht", "Veränderung","Verlust" nun die Begriffe "Information", "Komplexität" und "Erkenntnis" hinzu. Es öffnet sich das Tor zu mindestens einem weiteren Teil für diesen Essay, der den exakten Zusammenhang zwischen diesen Begriffen untersucht, nun wissend, dass die Entropie, eine fundamental-physikalische Zustandsgröße, auch für eine abstrakte Definition die Grundlage bildet.

Alle Darlegungen hier sind dabei im Fluß und können und werden sich ändern, solange sich die Entropie jenseits des Stoffwechsels in meinem Gehirn, noch nicht in einem Gleichgewicht befindet :-)

Weitere Fragestellungen aus diesen ersten Ableitungen

Es ergeben sich folgenden Fragen: - Wie also definieren sich "Information", "Komplexität" und "Erkenntnis" im Hinblick auf Entropie? - Gibt es so etwas wie eine vierte Klassifizierung als "statische" Entropie, also einen Prozess, bei dem alle Abläufe von vorneherein im Gleichgewicht sind, so dass wir sie nicht wahrnehmen? (damit ist nicht die verborgene Entropie gemeint, die vielleicht auch statisch wirkt, was aber nur daran liegt, dass wir entweder nur Ursache oder Wirkung von etwas sehen, nicht aber beides. Ich meine mit "statischer" Entropie eine Art Perpetuum Mobile von Ursache und Wirkung) - Wenn ja, welche Prozesse sind das und wie können sie entdeckt werden? - Kann Entropie tatsächlich nicht umgekehrt werden bzw. zerstört werden? Wären theoretische Konstrukte denkbar, die dies möglich machen und was wären die Folgen? - Was ist der Endzweck von Entropie? Vom Stoffwechsel in einer Zelle, hin zur Galaxie mit einer Sonne im Mittelpunkt und diese wiederum als ein Teil eines sich entropierenden Universums - wenn sich Entropie ausdehnt und die Zunahme der Entropie ein Verlust an Information bedeutet - was kann dann ihr Endzweck sein? - Lässt sich Entropie in passive Entropie, abhängig von festgelegten naturwissenschaftlichen Begebenheiten und in aktive Entropie, die von einem menschlichen Bewusstsein bewusst ausgelöst wird, unterteilen? - Welche sozialwissenschaftlichen Ableitungen drängen sich auf?

Ein 2. Teil des Essays ist bereits in Arbeit ... .